En este artículo explicamos qué es Databricks y cómo funciona. También repasamos las cinco características que hay que conocer para usar esta tecnología y explicamos por qué es importante.

Los datos en la era digital

Desde hace algunos años, el trabajo con datos pasó de ser importante a ser crítico en las organizaciones. Antes, si fallaba un modelo o un reporte, no afectaba el core de la empresa. Sin embargo, hoy los modelos de datos están cada vez más presentes en el negocio, por lo tanto, la falla en un pipeline de datos puede tener un impacto directo en la rentabilidad o pude incluso dejar a una parte de la organización sin poder operar.

Esta masificación del uso de los datos hacia adentro de las empresas genera una necesidad de adopción o de alfabetización, lo que les dio mucha más visibilidad a las áreas de data analytics puertas adentro.

Por lo tanto, la explosión en la demanda de datos por parte del negocio trajo como consecuencia la necesidad de usar nuevas herramientas y tecnologías que permitan procesar toda la información de una forma más amigable.

¿Qué es Databricks?

Databricks es una plataforma para el trabajo con datos que utiliza una forma de procesamiento distribuido. Es open-source, funciona solo en la nube (PaaS) y en entornos multicloud.

Desde hace algunos años, se convirtió en la solución ideal para quienes trabajan con datos porque —debido a su funcionamiento— simplifica notablemente el trabajo diario. Además, permite a los equipos de ingeniería, data science y arquitectura concentrarse en lo importante que es extraer valor a partir del procesamiento de los datos.

La empresa se fundó en 2013 por los creadores del proyecto Spark (Ali Ghodsi, Ion Stoica, Reynold Xin y Matei Zaharia). Por eso, podríamos decir que Databricks es una especie de distribución de Spark ya que la herramienta tiene un peso importante en su forma de funcionar.

Ali Ghodsi en su conferencia en el Data + AI Summit de Databricks en 2023

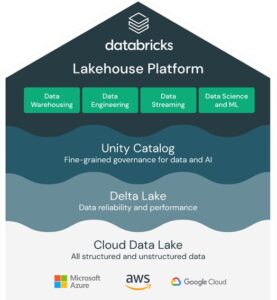

Databricks simplifica drásticamente las tareas de aquellos que trabajan en el ámbito de la data y la inteligencia artificial. ¿Cómo lo logra? Integrando todas las necesidades de datos en una sola solución. En lugar de desplegar múltiples servicios para abordar distintas necesidades como ingeniería de datos, ciencia de datos, inteligencia artificial, machine learning, business intelligence tradicional, gobierno de datos, streaming, entre otros, Databricks consolida todas estas tareas en un único lugar.

¿Cómo funciona Databricks?

Para funcionar, Databricks utiliza el concepto de procesamiento distribuido, que consiste en un conjunto de máquinas trabajando de manera coordinada como si fueran una sola entidad. Podemos imaginarlo como una orquesta donde cada máquina es un instrumento que contribuye a la armonía del conjunto.

Los sistemas distribuidos no son una novedad, de hecho, se remontan a los años sesenta. Sin embargo, fue en 2009 cuando surgió el proyecto Spark con el objetivo de superar las limitaciones en capacidad de almacenamiento y procesamiento de datos que existían hasta ese momento.

En el ámbito de la data y la analítica, trabajar con sistemas distribuidos se ha convertido en un estándar. ¿Por qué? Porque es la única manera efectiva de escalar y procesar volúmenes masivos de datos de manera rentable. Es la respuesta a la necesidad de manejar grandes cantidades de información de forma ágil y eficiente.

Databricks – Lakehouse Platform

Características que hay que conocer para empezar con Databricks

Las cinco principales características que tienen que saber quienes están empezando a explorar esta herramienta son:

- Databricks es una plataforma que utiliza Spark (open source) como motor de procesamiento.

- Databricks solo se ofrece como servicio en la nube.

- Se puede practicar gratis.

- Databricks es para cualquier perfil de datos.

- También es para personas usuarias de negocios.

En este artículo: Databricks: 5 características que hay que conocer para empezar con esta tecnología desarrollamos cada uno de estos puntos.

¿Por qué es importante Databricks?

Databricks está pasando de ser un aspiracional a ser la herramienta elegida para trabajar con datos y los número lo demuestran ya que, a comienzos de 2024, el market value de la empresa era de 43 billones de dólares.

Más allá de esto, lo interesante es que:

- El mismo equipo que diseño Spark y fundó la compañía, diez años más tarde, sigue haciendo lo mismo: gestionándola e involucrándose en el mundo open-source de los datos.

- Spark fue donado a la Apache Foundation (es decir, se liberó bajo la forma de software open-source) y se transformó en Apache Spark (plataforma con la que nos encanta trabajar).

- Crearon Delta Lake, un tipo de archivo que evoluciona las funcionalidades de ORC o Parquet y lo liberaron a la Linux Foundation.

- También desarrollaron MLFlow, probablemente la herramienta hoy en día más usada para gestionar el ciclo de vida completo de modelos de Machine Learning/AI (MLOps). También open-source.

- Crearon Delta Sharing, un protocolo para facilitar el intercambio de datos (data sharing), evitando copias redundantes o el intercambio de archivos como hacíamos en el pasado. Esto también fue liberado a la Linux Foundation.

- Y también Dolly y, más recientemente, DBRX. Modelos de Large Language Model (LLM)100% open-source y con licencia comercial.

Conclusión

Databricks simplifica la difícil tarea de configurar y administrar un cluster Spark. Esto es algo no menor ya que en Databricks el cluster se crea con solo algunos clicks.

En el artículo: ¿Cómo usar Databricks? explicamos con un video tutorial cómo usar la herramienta.

Databricks es para todos los perfiles de personas que trabajan con datos. Permite trabajar vía notebooks usando SQL, Python o R (los tres lenguajes de facto para el trabajo con datos hoy en día). Es decir, quien sabe SQL, R o Python, puede trabajar con Databricks y aprovechar toda la capacidad de cómputo que tiene detrás. También es para personas usuarias de negocio ya que, debido a que Spark lo permite, se le puede conectar cualquier herramienta de visualización de datos (Power BI, Tableau, MicroStrategy).

Básicamente, Databricks permite a quienes trabajan con datos evitar dedicar tiempo a cuestiones operativas (como el mantenimiento del cluster, de las librerías, etc.) para poder enfocarse en extraer valor de negocio a partir de los datos y esto, sin lugar a dudas, es algo que llegó para quedarse.